Prompt 调试

在开发 LLM 应用的过程中,高质量的提示词(Prompt)是至关重要的一环。Prompt 内容和模型的合理搭配,可以最大限度地激发模型的潜能,满足多样化、个性化的应用场景。

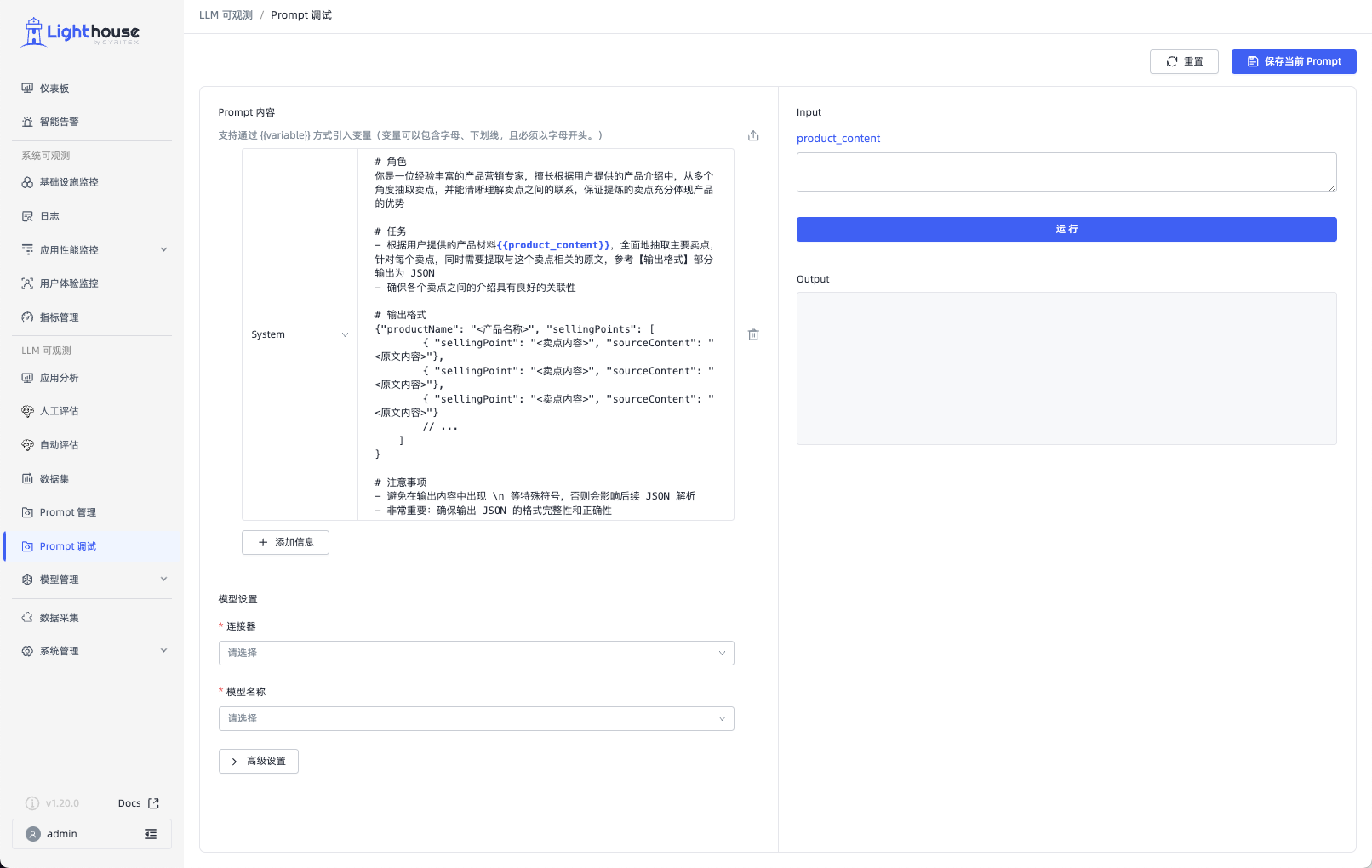

Lighthouse 的「Prompt 调试」功能,可以让您无需切换工具或编写代码,便可轻松调试和优化您的 Prompt。通过调整 Prompt 内容和模型设置,可以实时查看不同模型对不同 Prompt 变更的响应,从而快速找到优化方向,极大提高工作效率。

如何使用

步骤 1️⃣ :编辑 Prompt 内容

在当前页面的左上方的「业务 Prompt 内容」,您可以从无到有编写一个全新的 Prompt。

或者,点击右侧上传按钮,导入当前「Prompt 管理 - 业务 Prompt」模块已有内容,并可以在此基础上进行修改。

注意: 目前只支持导入 Chat 类型的业务 Prompt。

步骤 2️⃣ :设置模型

在当前页面的左下方的可以选择所用模型。

您需要提前在「模型 API」模块成功创建,才可以在此处使用相关模型。

同时,在高级设置中还可以配置相关的“温度”、“ Token 返回量上限”、“Top P”参数,精细化配置模型。

- 温度:调高温度会提高模型返回的多样性和创新性,数值范围为 0 到 2。反之,降低温度会使返回内容更加遵循指令要求但减少多样性。建议不要与“Top P”同时调整。

- Token 返回量上限:设置模型输出的最大 Token 数,数值范围为 0 到 4096。通常 100 Tokens 约等于 150 个中文汉字。

- Top P:设置模型的累计概率,限制模型只选择这些高概率的词汇,从而控制输出内容的多样性。数值范围为 0 到 1。建议不要与“温度”同时调整。

步骤 3️⃣ :填写 Input 所需变量值

若您第 1 步编辑的业务 Prompt 内容中包含变量,则需要在此处填写变量的值,从而模拟真实用户输入问题的场景。

步骤 4️⃣ :查看 Output 结果

前三步完成后,单击「运行」按钮,即可查看模型的返回结果。

根据返回结果是否达到预期,您可以继续调整 Prompt 内容或模型设置,直至找到最佳方案。

相关功能

保存当前 Prompt

在调试过程中,如果已达到预期效果,则可以在页面右上角单击「保存当前业务 Prompt」。目前支持两种保存形式:

-

将当前 Prompt 保存为一全新的业务 Prompt,并记录在「Prompt 管理 - 业务 Prompt」模块中,方便后续不断迭代和使用。

-

选择一个现有的业务 Prompt,将当前 Prompt 保存为该 Prompt 的一个最新版本。